Mission d'information sur la révision de la loi relative à la bioéthique

Réunion du mercredi 7 novembre 2018 à 12h40

Résumé de la réunion

La réunion

Mission d'information DE LA CONFÉRENCE DES PRÉSIDENTS SUR LA RÉVISION DE LA LOI RELATIVE À LA BIOÉTHIQUE

Mercredi 7 novembre 2018

Présidence de M. Xavier Breton, président de la Mission

La Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique procède à l'audition de M. Cédric Villani, député de l'Essonne, vice-président de l'OPECST, auteur d'un rapport sur l'intelligence artificielle.

L'audition débute à douze heures quarante.

Mes chers collègues, nous achevons cette matinée d'auditions en accueillant notre collègue Cédric Villani, député de l'Essonne, vice-président de l'Office parlementaire d'évaluation des choix scientifiques et technologiques (OPECST) et auteur d'un rapport sur l'intelligence artificielle intitulé Donner un sens à l'intelligence artificielle : pour une stratégie nationale et européenne. Cher collègue, nous vous remercions d'avoir accepté d'intervenir devant nous.

Dans ce rapport publié à la fin du mois de mars dernier, vous identifiez la santé comme l'un des secteurs à forte potentialité pour l'utilisation de l'intelligence artificielle. Nous en sommes parfaitement conscients et notre rôle va consister à réguler le cas échéant ces technologies, en prenant en compte les différentes problématiques éthiques qui se posent, sans pour autant entraver excessivement la recherche et ses applications. Votre expertise va nous être bénéfique pour définir au mieux un juste équilibre entre ces deux notions dans la perspective de la loi qui se prépare. Je vais vous laisser la parole pour un exposé, puis nous aurons un temps d'échanges.

Merci, mes chers collègues. Avant de commencer et puisque notre rapporteur est attaché au territoire lyonnais, je mentionnerai que sur les questions d'articulation entre mathématiques et médecine, la région de Lyon a été pionnière, en particulier avec mon ancien collègue de l'École normale supérieure de Lyon Emmanuel Grenier. Il m'est arrivé, il y a quelques années, d'effectuer dans cette ville, dans un contexte hospitalier, de grands exposés sur les apports de l'intelligence artificielle à la médecine. Je dois dire aussi que lorsque ces travaux ont démarré, ils ont été assez peu pris au sérieux par la communauté mathématique. Nous étions alors vers la fin de la période pendant laquelle l'intelligence artificielle avait mauvaise presse, si bien que l'on ne misait guère dessus.

Je commencerai par prendre quelques minutes pour évoquer le contexte de l'intelligence artificielle et les questions d'efficacité sous-jacentes. Je dirai ensuite quelques mots du rapport, avant d'insister sur les enjeux éthiques, en particulier dans le cadre du projet de loi à venir. Je m'attacherai à présenter un exposé succinct, afin de laisser autant de temps que possible à la discussion.

Le sujet de l'intelligence artificielle n'est pas neuf. Il est né dans les années 1950 et s'est développé, pendant très longtemps, avec des à-coups. Ces travaux avaient pour objet la compréhension des processus de l'intelligence humaine et leur reproduction in silico. C'est d'ailleurs de là que provient la dénomination, si mal choisie, d'« intelligence artificielle ». Passés les grands espoirs initiaux, le programme a été largement désavoué dans les faits, si bien que jusque dans les années 1990, le sujet était considéré comme peu effectif, gardant une identité éthérée. Le voir ensuite progresser si vite a constitué, dans les années 2000 et plus encore dans les années 2010, une réelle surprise. Personne, ni dans la sphère des décideurs ni dans celle des experts, n'avait en effet anticipé ce mouvement.

Quelles sont les raisons pour lesquelles l'intelligence artificielle est devenue si omniprésente au cours des dernières années, à la fois dans le discours et les techniques ? Cela tient d'une part au fait que les techniques statistiques ont gagné en ampleur, en raison de la constitution de gigantesques bases de données, d'autre part à l'accélération de la puissance de calcul. D'autres facteurs entrent certainement également en jeu, que les chercheurs et les spécialistes en algorithmique continuent à essayer de comprendre. Ainsi, nous ne savons pas précisément pourquoi les algorithmes que nous utilisons actuellement sont si efficaces. Il ne faut surtout pas y voir une sorte d'émergence de conscience ou d'intelligence : cela vient simplement d'une sous-estimation de la puissance des techniques statistiques dans l'analyse de données issues du monde réel. Cela traduit aussi le fait que nous manquons encore d'explications sur la façon dont les données du monde réel s'organisent et sur la raison qui fait que, dans beaucoup de situations concrètes, des phénomènes qui semblent dépendre d'un très grand nombre de paramètres se rapportent finalement à un petit nombre de paramètres efficaces.

Au-delà de cette montée en puissance des méthodes statistiques, un coup de théâtre s'est produit au plan technique, dans les années 2010, avec la redécouverte des techniques dites de « réseaux de neurones », ou d'« apprentissage profond ». Les réseaux de neurones sont connus depuis longtemps et les algorithmes qui font fureur aujourd'hui datent des années 1980. Or, il y a moins d'une décennie encore, les experts les plus reconnus en informatique les considéraient comme une impasse et estimaient qu'il était vain de poursuivre des recherches dans ce domaine. C'était sans compter sur la ténacité de la petite équipe de Yann LeCun, Yoshua Bengio et Geoffrey Hinton, qui a démontré que ces réseaux de neurones pouvaient être extrêmement efficaces lorsqu'ils étaient bien manipulés, même si les plus grands experts du domaine ne s'expliquent toujours pas clairement les raisons profondes de cette efficacité.

Ce domaine s'est donc développé d'une façon extraordinairement pragmatique, avec assez peu de théorie, et de manière extrêmement statistique, c'est-à-dire en se fondant sur des exemples et de grandes bases de données. Là où, vingt ans plus tôt, on aurait pensé que la clé de l'intelligence artificielle résidait dans la compréhension subtile de mécanismes logiques, on se rend compte aujourd'hui que les enjeux en termes d'efficacité se trouvent surtout dans de grandes bases de données et une énorme puissance de calcul.

Il faut ajouter aux données et aux moyens de calcul un troisième ingrédient autour duquel se joue une compétition nationale et mondiale : il s'agit des cerveaux humains capables de programmer et de mener des projets dans le domaine de l'intelligence artificielle.

Ces trois éléments donnent lieu à une compétition internationale phénoménale, qui se tend d'année en année et dans laquelle le leader émergent est la Chine, qui investit des montants sans commune mesure avec ceux que les autres pays y consacrent. J'en veux pour preuve le fait que, tout récemment, la présidente de la région Ile-de-France a annoncé un grand concours d'intelligence artificielle, financé à hauteur de 20 millions d'euros, visant à faire émerger de nouvelles solutions ; à peu près au même moment, une grande ville chinoise a annoncé un investissement de 15 milliards d'euros pour les années à venir. Tout est à l'avenant. Alors que l'on pouvait estimer, il y a vingt ans, que l'élément essentiel n'était pas l'argent mais la compréhension subtile des phénomènes, le débat s'est déplacé aujourd'hui et l'argent achète tout, qu'il s'agisse des moyens de calcul ou des cerveaux. La question des données est de nature différente ; mais la constitution de grandes bases de données n'est pas non plus un problème en Chine.

Voici donc, brièvement présenté, le contexte technologique et géopolitique qu'il convient d'avoir présent à l'esprit. Nous pourrons y revenir si vous le souhaitez.

Parlons maintenant de l'application de l'intelligence artificielle à la médecine. Tout est envisageable, avec plus ou moins de succès : tout est affaire de pratique. Certaines tâches se sont avérées traitables par l'algorithmique sophistiquée de façon beaucoup plus efficace qu'on ne l'imaginait, contrairement à d'autres. De façon générale, les intelligences artificielles sont très efficaces pour reconnaître des situations, des motifs, effectuer des diagnostics, c'est-à-dire, globalement, réaliser des analyses à partir de cas précis. En matière médicale, cela se traduit notamment par la réalisation de diagnostics automatiques. Citons le cas emblématique, et notoirement difficile à traiter par les humains, du diagnostic du cancer du sein : les algorithmes de reconnaissance automatique sont actuellement à peu près au même niveau que les humains. Lorsque l'on combine les deux aspects, algorithmique et humain, on obtient un taux de succès très proche de 100 %.

Les algorithmes permettent également la reconnaissance automatique de certaines configurations, en particulier dans l'analyse génomique, la traduction automatique de génotypes en phénotypes – problème resté notoirement insoluble pour les cerveaux humains pour l'instant –, toujours en se basant sur l'exemple, sur des situations déjà rencontrées et suffisamment documentées.

L'intelligence artificielle permet enfin, de façon plus générale, l'optimisation de processus à partir de divers paramètres et contraintes.

Il existe ainsi des applications importantes de l'intelligence artificielle en médecine et plus globalement dans l'interaction entre biologie et algorithmique.

Tout cela peut sembler a priori très positif. Nous disposons déjà d'exemples dans lesquels un diagnostic automatisé a permis de sauver la vie de tel ou tel patient dont la pathologie avait été sous-estimée par un médecin.

Pour autant, se posent en regard un certain nombre de problèmes éthiques. Ainsi, le rapport sur l'intelligence artificielle que j'ai coordonné, s'il insiste sur la santé comme étant l'un des secteurs dans lesquels il faut investir de façon importante, pointe aussi de potentiels risques et dérives, qui sont aujourd'hui de mieux en mieux documentés.

De façon générale, les risques de l'intelligence artificielle peuvent tout d'abord venir de l'usage de l'algorithmique, c'est-à-dire d'un processus défectueux ou mal utilisé. Cela peut être le fruit d'un algorithme insuffisamment testé ou validé, ou d'une utilisation sans précaution, par une personne ne maîtrisant pas le processus. Cela peut encore provenir d'une dilution de responsabilité dans une chaîne humaine, conduisant à ce qu'un comportement dangereux ne soit pas identifié. Le dysfonctionnement peut se situer à l'interface entre l'humain et le système automatique, avec une perte de savoir-faire humain. Il peut enfin relever d'une mauvaise interprétation.

Une deuxième catégorie de problèmes éthiques est liée au rapport avec les données et les informations. La collecte de grands jeux de données implique de déployer beaucoup d'énergie. Un rapport, coordonné par Mme Combes et rendu récemment à la ministre de la santé, préfigure la mise en place d'un grand système national public de données de santé, agglomérant des données administratives et des données issues des hôpitaux et de différents registres. Ce travail met en lumière les difficultés que ces données vont susciter : problèmes de format, d'autorisation, d'ingénierie administrative des bases de données. Qui a le contrôle ? Qui donne l'autorisation ? Qui permet que telle donnée soit collectée et pas telle autre ? Qui va vérifier que les bases de données sont bien calibrées ? Les questions sont nombreuses.

Prenons un exemple parmi beaucoup d'autres, qui s'est présenté à plusieurs reprises : aujourd'hui, lorsqu'un geste chirurgical est effectué et qu'il faut inscrire les données correspondantes dans le système national des données de santé (SNDS), il faut savoir que le geste indiqué dans les bases de données administratives n'est pas celui qui a effectivement eu lieu : c'est le geste provisoire à partir duquel les remboursements sont effectués. Or, entre le moment où un nouveau geste est introduit dans la pratique médicale et le moment où tous les acteurs se sont entendus sur une base de remboursement, il peut s'écouler des années, pendant lesquelles le vrai geste sera consigné dans les registres hospitaliers par le chirurgien, mais ne figurera pas dans les bases de données de l'État. Tant que la seule finalité était un remboursement du patient, cela était acceptable ; mais dans la mesure où il va s'agir d'en tirer des informations statistiques pour savoir si telle ou telle méthode est efficace ou pour connaître le taux de rechute, alors ces données risquent d'induire en erreur, en particulier au moment le plus crucial qui est justement celui de l'introduction d'un nouveau geste chirurgical. Il existe donc des difficultés techniques réelles pour l'exploitation des données en vue d'une plus grande efficacité.

Au-delà, il importe aussi de considérer les difficultés éthiques ou légales. Quand a-t-on le droit de placer telle ou telle donnée dans un fichier ? Qui peut y avoir accès ? Qui va indiquer au patient les informations le concernant susceptibles d'être déduites de ces données ? Des organismes d'assurance y auront-ils accès ? Va-t-on pouvoir mettre en oeuvre des algorithmes prédictifs à partir de telle ou telle donnée, par exemple génétique ?

Lors de l'élaboration du rapport sur l'intelligence artificielle, et plus encore dans les discussions menées à l'OPECST sur la bioéthique, ces questions d'information et de prédiction ont donné lieu aux débats les plus complexes. Cela se reflète dans les avis figurant dans le rapport de l'OPECST. Quelle attitude avoir, par exemple, face à la pratique consistant pour un individu à faire séquencer son génome à des fins non thérapeutiques, chose pour l'instant interdite par la loi française, mais néanmoins assez facile à réaliser en passant par un opérateur étranger ? Certains prônent la légalisation par pragmatisme, tandis que d'autres pensent qu'il faut maintenir l'interdiction, ne serait-ce que par cohérence avec un ensemble de règles susceptibles d'être affectées par un tel changement, en rapport notamment avec le droit de la filiation ou les indemnisations. Un autre exemple est celui du cloisonnement entre les données de santé et les mutuelles, débat sur lequel le Sénat et l'Assemblée nationale ne partagent pas la même position ; ce clivage se retrouve d'ailleurs dans l'avis rendu par l'OPECST, puisque le rapporteur de l'Assemblée nationale et la rapporteure du Sénat n'ont pas réussi à se mettre d'accord sur la question. Bref, nous sommes dans une situation de transition, d'évolution, dans laquelle un certain nombre de pratiques et de recommandations ressemblent à une cote mal taillée, entre différents idéaux et volontés. Ce n'est pas grave en soi dans le cadre d'une loi de bioéthique, toujours amenée à insister sur des questionnements, parfois à ne pas trancher de façon claire et à laisser la place à la réflexion éthique des personnes en situation de responsabilité, dont les médecins.

Si je me résume, se posent une question d'efficacité, mais aussi des difficultés techniques et des problèmes beaucoup plus importants liés à l'éthique et en particulier à l'information : qui a le droit de savoir ? Faut-il informer ou non ?

Pour terminer, je souhaite soulever une question liée, dans ce contexte, au rôle du patient. Toutes sortes de questionnements nouveaux se manifestent en ce domaine. Le patient a-t-il le droit de s'informer lui-même sur des questions que l'institution lui dénie pour l'instant ? Que signifie pour le patient le fait de donner son consentement éclairé, base sur laquelle repose actuellement le recueil de données personnelles ? Quel sera le rapport du patient aux possibilités d'information qui seront ouvertes ? Je conclurai en faisant référence aux propos d'un collègue de l'Académie de médecine, entendu dans le cadre d'un groupe de travail conjoint avec l'Académie des sciences : il nous invitait à ne pas nous tromper d'ennemi, car le vrai problème qui guette les gens avec le développement de l'algorithmique dans la santé est le syndrome du patient en proie à une multitude de hantises et de craintes sur ce qui pourrait lui arriver, hantises et craintes qui lui gâcheraient finalement beaucoup plus l'existence que les maladies elles-mêmes.

Je me tiens, chers collègues, à votre disposition pour revenir sur n'importe lequel de ces éléments ou sur tout autre point en rapport avec l'intelligence artificielle et l'évolution de la santé qui vous semblera important.

Merci, cher collègue.

Je commence ce temps d'échange par deux questions. Vous avez évoqué les algorithmes défectueux comme étant l'un des problèmes à surmonter. Seriez-vous favorable à l'instauration de modalités nouvelles de certification, peut-être plus contraignantes, dans le domaine de la santé, afin de garantir la sécurité et l'efficacité de ces algorithmes ? Dans l'affirmative, quelles pourraient être les modalités pratiques de cette certification ?

Vous avez également abordé la question de l'explicabilité des algorithmes. Seriez-vous favorable à ce que soit introduite dans la loi à venir une exigence d'explicabilité des algorithmes ? La portée devrait-elle en être différente selon la personne destinataire : patient, professionnel de santé, etc. ? Cela vous semble-t-il réalisable dans le cas des algorithmes dits « auto-apprenants », qui ont un mode de fonctionnement différent, par définition plus difficile à expliquer ?

Je suis favorable à la certification, mais avec certaines réserves. Il ne faut pas se méprendre. Rappelons que l'intelligence artificielle recouvre un ensemble très disparate d'algorithmes. J'ai insisté sur l'apprentissage statistique, qui fonctionne par l'exemple. Mais il ne faut pas oublier les algorithmes de systèmes experts, qui ont connu leur heure de gloire voici quelques décennies et reposent davantage sur la logique, en transcrivant en algorithmique un savoir-faire humain, une compétence acquise. Il existe une troisième catégorie d'algorithmes qui se fonde sur l'exploration des possibles et va jouer un rôle de plus en plus important, associé à la simulation dans certaines situations. Cela a par exemple fait la gloire de la société DeepMind et de son algorithme AlphaGo, qui écrase les meilleurs spécialistes humains au jeu de go. Ces programmes ne font en rien appel aux exemples et doivent tout à l'exploration.

En médecine, cependant, on reste très attaché soit aux systèmes experts, soit aux exemples. Dans le cadre d'une éventuelle certification d'un algorithme reposant sur les exemples, l'algorithme en soi s'efface devant le problème de la qualité de la base de données. La question la plus importante est de savoir comment est constituée celle-ci, de s'assurer qu'elle ne comporte pas de biais, qu'elle est aussi large que possible et recouvre bien le domaine concerné. Permettez-moi de vous faire part d'un exemple caricatural, mais inspiré d'une histoire vraie : imaginez un algorithme conçu pour distinguer, à partir d'une image médicale, une tumeur bénigne d'une tumeur maligne, et calibré à partir d'une banque de données issue pour partie d'un service dans lequel on traite les tumeurs les plus graves, et pour une autre partie d'images de tumeurs bénignes, collectées un peu partout. Très rapidement, l'algorithme va apprendre non pas à distinguer les tumeurs malignes des tumeurs bénignes, mais à reconnaître la provenance des images qui lui sont soumises, à partir de signes imperceptibles. C'est un peu comme si, dans le domaine militaire, l'on entraînait un algorithme à distinguer les chars utilisés en Sibérie des chars utilisés par les États-Unis : très vite, l'algorithme apprendra à reconnaître si l'image comporte ou non de la neige, plutôt qu'à se concentrer sur l'étude de la forme du char. La question essentielle ici est donc de savoir si la base de données a été bien pensée pour éliminer les biais. Dans certains cas les biais sont inévitables ; il faut alors voir ce qui a été mis en oeuvre pour les supprimer.

Il existe des algorithmes pour lesquels il est possible d'effectuer une certification en bonne et due forme. La France est d'ailleurs leader en la matière, en particulier via les travaux de l'Institut national de recherche en informatique et en automatique (INRIA), pour vérifier qu'un algorithme est absolument conforme à ce qui est attendu de lui et qu'il donnera dans tous les cas la bonne réponse. En pratique, sur des codes issus de situations réelles, venant de l'industrie, ces techniques ne sont pas applicables sur la totalité du code, car les vrais codes sont très grands, sans cesse mouvants, et la combinatoire des possibles est immense. Il n'est alors pas possible d'exiger une telle vérifiabilité.

Dans un tel contexte, quelle pourra être la certification proposée ? Il pourra d'abord s'agir d'un certificat apporté par une agence d'experts, qui aura à coeur d'appliquer un certain nombre de méthodes de vérification. Pour certains pans vitaux de l'algorithme, on pourra mettre en oeuvre des techniques de vérification, en instruisant sur la manière dont la base de données a été constituée, en effectuant des tests, en introduisant de fausses données dans l'algorithme afin de voir comment il se comporte, etc. Il faudra utiliser un ensemble disparate de méthodes pour aboutir à une certification. La certification pourra aussi prendre la forme de normes de qualité sur la façon dont le système a été conçu, dont le code a été rédigé. Les grands acteurs américains du secteur, qui doivent actuellement résoudre des problèmes de confiance dans leur rapport aux citoyens, ont commencé à mettre en place de telles procédures, non seulement pour effectuer un contrôle interne, mais aussi pour afficher des guides de bonnes pratiques vis-à-vis de l'extérieur.

Pour lutter contre les algorithmes défectueux, il sera important qu'un comité indépendant travaille non sur la question de savoir si tel ou tel algorithme est bien réalisé, mais sur le principe de son usage. C'était l'une des principes recommandations, en matière d'éthique des algorithmes, de notre rapport sur l'intelligence artificielle. Nous préconisions en effet la mise en place d'un comité indépendant, sur le modèle de l'actuel Comité consultatif national d'éthique pour les sciences de la vie et de la santé (CCNE). Je continue à recommander que cette instance soit, à terme, distincte du CCNE, ce qui n'exclut pas des saisines communes, ni sans doute des membres communs aux deux comités, dans la mesure où certaines questions relèvent à la fois de l'intelligence artificielle et de la bioéthique. En revanche, d'autres problèmes n'ont rien à voir avec la biologie : ils relèvent purement de l'éthique des algorithmes et font intervenir des savoir-faire très différents. Il est cependant envisageable d'inscrire, dans la loi de bioéthique à venir, une solution transitoire dans laquelle, au sein du CCNE, serait mis en place un nouveau collège chargé de gérer ces questions d'intelligence artificielle. Cette option présenterait l'avantage de permettre un transfert de savoir-faire efficace sur la façon dont doit fonctionner un comité d'éthique indépendant, mais aussi d'afficher clairement, vis-à-vis des citoyens, que l'on a bien perçu l'urgence d'une réponse appropriée. Pour autant, je continue à penser que sur le long terme, un comité d'éthique de l'intelligence artificielle, indépendant, séparé, permettra de répondre à la diversité des enjeux dans ce domaine, comme l'ont exposé de façon emblématique des ouvrages tels que celui de Catherine O'Neil sur les dérives possibles de l'intelligence artificielle. Cela permettra aussi d'afficher le fait que l'on prend ces questions très à coeur, et pas seulement en matière de bioéthique.

Au plan technique, le rapport sur l'intelligence artificielle se prononçait en faveur de la mise en place d'une sorte de corps d'inspecteurs assermentés pour explorer les algorithmes, qui auraient vocation à être renouvelés régulièrement afin d'être parfaitement au fait des technologies et de leurs avancées.

Votre deuxième question portait sur l'explicabilité. Il s'agit de comprendre, lorsqu'un algorithme a rendu son verdict, pourquoi il s'est prononcé de la sorte. Le but n'est pas de disposer du détail du calcul effectué, mais d'un ensemble de raisons compréhensibles par un humain. Il faut en quelque sorte extraire d'un océan de données les quelques facteurs qui ont le plus joué pour faire pencher la balance du diagnostic d'un côté ou d'un autre. Cette explicabilité est en partie subjective. Elle doit également – et c'est difficile – être compréhensible et vérifiable par un cerveau humain. Cette problématique se posera par exemple au médecin lorsque, face à un diagnostic suggéré par l'algorithme, il souhaitera vérifier, à partir de ses propres connaissances, qu'il partage cet avis. Ce sera également important pour des raisons de responsabilité. Il est essentiel de ne pas tout déléguer aux machines et de laisser la responsabilité à l'humain, que ce soit dans le domaine médical ou dans celui de la mobilité. A la fin des fins, il faudra qu'un ou des humains soient responsables, avec éventuellement un partage des responsabilités. Le fait que l'algorithme ne soit pas explicable rendra plus fragile cette notion de responsabilité.

Pour autant, il faut aussi avoir conscience que le critère principal pour qu'une technologie soit adoptée, tant par les patients que par les experts, est son efficacité. En pratique, cela prime sur l'explicabilité. De la même manière, nous conduisons des véhicules non parce que nous savons parfaitement comment ils fonctionnent, mais parce qu'ils ont été testés par des gens auxquels nous faisons confiance et expérimentés par beaucoup d'autres.

Il est important de continuer à mener des recherches sur cette question de l'explicabilité, sans pour autant la considérer comme un facteur limitant, impératif, sine qua non de l'acceptabilité des algorithmes.

Les algorithmes auto-apprenants ne sont pas antinomiques de l'explicabilité : ce n'est pas parce que l'algorithme a déterminé tout seul, au fur et à mesure des données disponibles, la façon dont il fonctionne, que l'on ne parviendra pas à l'expliquer. Les recherches en explicabilité consistent précisément à essayer de retrouver a posteriori les facteurs ayant le plus joué. Par analogie, c'est comme si vous-même, système complexe, aviez agi dans telle situation d'une façon incompréhensible y compris par vous, et que votre psychanalyste parvenait, au bout d'un certain nombre de séances, à vous faire comprendre a posteriori la logique qui vous animait de façon inconsciente. Il s'agit de même de déterminer a posteriori les raisons pour lesquelles un algorithme a rendu tel ou tel verdict.

Merci infiniment pour toutes ces explications, ainsi que pour le rapport précédemment fourni.

Nous disposons en France de l'une des plus grandes bases de données de santé, grâce à notre système d'assurance maladie et à nos hôpitaux publics. Pour autant, l'utilisation en est pour l'instant incomplète et parfois un peu faible. Prenons l'exemple de l'épidémiologie : on voit bien actuellement comment les malformations, telles que celles des nouveaux-nés sans bras, ne sont pas identifiées en temps réel et d'une façon satisfaisante. Nous avons toutes les données, mais leur exploitation laisse à désirer. À quoi peut-on attribuer cela selon vous ? Est-ce dû à des moyens financiers insuffisants ? À une volonté trop peu affirmée ? Comment aller plus vite dans ce domaine et faire en sorte que la France conserve une place dans la compétition internationale ? La question des moyens financiers est, selon moi, centrale. Comment faire comprendre que l'investissement trouvera très rapidement sa propre rentabilité ? J'en suis convaincu, mais encore faut-il le démontrer pour que les montants nécessaires soient dévolus à cette utilisation des données de santé.

Il est également important que la confidentialité soit assurée, particulièrement pour les données de santé. Néanmoins, on n'empêchera pas que des personnes puissent s'introduire dans tel ou tel système. La meilleure formule n'est-elle pas de mettre en place une dissuasion, par l'intermédiaire de pénalités importantes visant ceux qui – employeurs, assureurs, que sais-je encore ? – voudraient utiliser de façon inopportune des données confidentielles personnelles ?

D'aucuns s'inquiètent de l'utilisation commerciale des données dès aujourd'hui. Il n'est pas rare de recevoir des publicités ciblées, nous proposant des objets connectés dont nous n'avons pas forcément besoin, correspondant précisément aux pathologies qui nous concernent, aux achats que nous avons faits précédemment, etc. Tous ces envois sont très personnalisés, ce qui signifie qu'il existe des fuites dans les différents circuits, qui permettent à des sociétés commerciales d'utiliser nos données. Comment contrôler cela ?

A également été évoqué le fait que, pour les patients, les prédictions émanant notamment des données génétiques étaient susceptibles de générer des craintes vis-à-vis de ce qui pourrait arriver. Or l'espèce humaine est mortelle. Quel risque pire que la mort encourons-nous ? Je ne suis pas sûr qu'il en existe de plus considérable. Ce risque nous est connu, même s'il faudrait peut-être, dans nos civilisations, que chacun en ait davantage conscience. Pour le reste, il n'est pas mauvais de savoir à l'avance certains des risques que l'on encourt, car cela permet d'adapter son comportement. Celui qui, par exemple, risque de développer une hypertension consommera moins de sel et fera de l'exercice physique. Celle qui a des gènes prédisposant au cancer du sein fera des mammographies plus fréquentes, sera traitée plus tôt et guérira. Il existe certes une part de crainte, mais aussi un bénéfice à tirer de ces prédictions. Il faut donc évaluer les deux pour savoir ce qu'il est opportun de révéler aux personnes et ce qui conduirait à nourrir des craintes inutiles. Comment trouver le moyen terme entre l'attitude américaine consistant à livrer indistinctement toute l'information disponible au motif qu'elle appartient à l'individu, et l'attitude française consistant à ne rien révéler afin d'éviter que les gens soient dans l'inquiétude, quitte à ce que certains fassent séquencer leur génome à l'étranger et se retrouvent seuls face à des données qu'ils ne comprennent pas ?

Ma dernière question reprend le point développé sur le comité d'éthique, spécifique à l'intelligence artificielle, distinct du CCNE même s'il émerge à partir de celui-ci en tirant expérience de son savoir-faire. Je suis tout à fait favorable à cette idée, mais ne serait-il pas intéressant, au-delà de l'application de l'intelligence artificielle à l'humain, d'en étendre le champ au reste du monde vivant ? De plus en plus, en effet, les autres espèces vivantes, l'environnement lui-même, vont bénéficier de l'utilisation de l'intelligence artificielle. Là encore, des questions éthiques se posent, vis-à-vis de telle espèce en voie de disparition et de la biodiversité en général. Quel est votre sentiment sur ce point ?

Concernant les bases de données, je vous recommande la lecture du rapport Combes, qui dresse un excellent panorama du contexte et constitue une très bonne préfiguration de ce que serait un grand système de bases de données.

Quels sont les éléments qui limitent pour l'instant l'utilisation de nos grandes bases de données ? Le premier facteur est qu'elles sont insuffisamment structurées. Les difficultés d'utilisation de la gigantesque base de données qu'est le système national d'information inter-régimes de l'assurance maladie (SNIIRAM) le montrent bien. S'ajoute à cela le fait qu'elles ne sont pas portées par des matériels très rapides. En France, Emmanuel Bacry est celui qui a le plus travaillé, dans le cadre de l'École Polytechnique, pour développer la recherche sur le SNIIRAM et tout ce qu'il est possible d'en tirer. Sa compétence ne fait aucun doute et l'on peut donc lui faire confiance lorsqu'il indique que cette base est très difficile à exploiter, en raison de la manière dont les informations y sont rangées.

Le deuxième facteur limitant concerne le besoin d'interconnexion des bases de données. Si l'on consulte le SNIIRAM, on peut, par exemple, apprendre qu'un patient a été remboursé pour tel acte ou tel médicament, mais rien n'indique s'il est mort ou s'il a survécu. Lorsqu'il s'agit d'envisager l'efficacité d'un acte ou d'un traitement, cela pose un problème... Un patient peut également aller en milieu hospitalier, puis bénéficier d'une consultation en ville ou se retrouver en discussion avec sa mutuelle sur un sujet donné : c'est dans la connexion de toutes ces bases de données, détenues par des acteurs différents, avec des responsabilités et des systèmes différents, que l'on va générer la meilleure valeur ajoutée. Or c'est un véritable casse-tête. Il appartient à l'État de garantir l'interconnexion et de créer la plateforme sectorielle de santé sur laquelle les applications pourront s'appuyer ; il appartient aux start-up de tester leurs développements et aux hôpitaux de chercher à mettre en oeuvre des solutions « maison ».

La sincérité des informations peut aussi être un frein. J'ai évoqué précédemment la question de la réalité des actes inscrits dans ces bases, en distinguant l'acte effectif de l'acte remboursé. Des erreurs de transcription sont également possibles. Il est donc nécessaire de développer des outils permettant d'analyser les rapports écrits par les praticiens, par les internes, et de les transformer en informations structurées. Une information n'a de valeur que si elle est correctement structurée et rangée dans les bonnes cases, selon un certain nombre d'axes. Les systèmes les plus efficaces pour exploiter les bases de données médicales, dont celui mis en oeuvre par Israël, qui fait référence en la matière au niveau international, sont ceux dans lesquels les données sont rangées de la façon la plus systématique, dans un contexte de contrainte très forte sur les praticiens, avec un enregistrement des données bien avant que l'on sache comment les utiliser.

Imaginons que différents acteurs se soient entendus pour créer une base de données. Vient alors la question de la réalisation pratique, avec un triple défi à relever.

Le premier est technique : il s'agit de disposer de matériel hardware à niveau, des bons formats, des certifications adéquates et de la cybersécurité, dans un contexte où la sécurité va s'imposer comme un problème de plus en plus important pour toutes les institutions. Les actions de piratage sont en effet amenées à se multiplier, qu'elles soient le fait d'individus ou d'États. Cette question technique ne doit pas être négligée.

La deuxième difficulté à surmonter est légale et éthique : cela suppose des discussions avec la Commission nationale de l'informatique et des libertés (CNIL) et l'Institut national des données de santé (INDS) lorsqu'il s'agit de sujets de recherche. Or la délivrance des autorisations nécessaires pour mener des projets de recherche prend parfois plusieurs années, ce qui peut s'avérer mortel pour une start-up qui veut mettre en place un modèle de diagnostic automatique, ou empêcher un hôpital de gérer tel ou tel projet. Ce deuxième défi a été bien identifié par les acteurs en situation de responsabilité. La CNIL a ainsi effectué un travail considérable à base de référentiels, d'assouplissement et d'évolution de doctrine pour raccourcir les délais. Mais il faut une vigilance permanente pour éviter que ces délais ne se rallongent.

Le troisième défi, le plus sous-estimé, concerne la gouvernance. L'Assistance publique Hôpitaux de Paris (AP-HP) avait rapporté, lors de son audition, qu'il n'avait pas fallu moins longtemps pour résoudre ce problème de gouvernance que pour aplanir les difficultés techniques. La gouvernance consiste à décider comment les données vont être accessibles, par qui, qui aura la responsabilité, qui pourra décider de donner tel ou tel accord. Cela relève d'un jeu de pouvoir entre humains, toujours très difficile à régler. L'intelligence artificielle est basée sur le partage des données. Or, lorsque les gens comprennent que les données sont précieuses, le réflexe naturel est d'éviter qu'elles partent. Un hôpital aura scrupule à partager ses données avec un autre. Un département d'une grande entreprise peinera de même à communiquer ses données au département voisin. Cela peut s'expliquer par la crainte d'une mauvaise prise en charge de la cybersécurité, ou par un souci d'équité. Il existe ainsi des freins culturels à vaincre.

Tous ces problèmes ont été assez bien identifiés par les autorités, le ministère ou des acteurs comme l'Institut national de la santé et de la recherche médicale (INSERM). Un arbitrage important rendu dans le prolongement de la mission que j'ai coordonnée concernait le fait qu'un système de bases de données de santé devait être aussi large que possible du point de vue des thématiques couvertes, qu'il ne s'agissait pas de construire un système d'exploitation de la base de données administrative du SNIIRAM sans prendre en compte les autres bases.

En termes de protection de la confidentialité des données, la dissuasion est en général une assez bonne arme. Le règlement général de protection des données (RGPD) repose ainsi sur des dissuasions fortes, avec un système de confiance a priori, de contrôle a posteriori, et des amendes considérables en cas de manquement. Cela permet d'éviter des procédures trop lentes. Mettre trop de filtres à l'entrée, par exemple sous forme de demandes d'autorisation, freine en effet les procédures, dans un contexte où l'on a besoin, au contraire, de suivre un rythme de développement technologique très rapide.

La confidentialité peut être difficile à maintenir dans un contexte de données ouvertes. Cela suscite un débat délicat et très technique, qui impose d'évoquer la question du statut des données. Dans la doctrine française, et plus généralement européenne, les données ne sont pas propriété de la personne qui en est à l'origine. Elles ne sont pas non plus la propriété du producteur de données, mais s'apparentent à un bien commun, dans la mesure où elles peuvent nourrir un pool d'autres données et où c'est la conjonction de ces données qui va fournir la valeur statistique. Les données d'un individu ne permettent pas à elles seules de faire avancer la recherche médicale ; elles doivent pour ce faire être rapprochées de milliers d'autres dossiers. Seule la considération d'un ensemble statistique permettra de faire émerger des informations. Les données sont donc un bien commun dont l'utilisation est soumise à autorisation de la part du producteur de données et de la personne à laquelle les données se rapportent. Cette doctrine, en vigueur actuellement, s'oppose à la commercialisation de ces données, en particulier par la personne sur laquelle elles ont été prises.

L'utilisation des données suppose donc une mise en commun avec d'autres données. Plusieurs options se présentent. Le Président de la République a annoncé, lors de la présentation de la stratégie nationale en matière d'intelligence artificielle, l'ouverture des données de santé : toute donnée de santé pouvant être utile pour faire progresser la connaissance publique et la santé doit être rendue accessible. Cela étant posé, beaucoup de problèmes restent à résoudre. Comment et jusqu'à quel point anonymiser les données ? Qui y aura accès ? Seront-elles regroupées dans un pot commun ou resteront-elles dans des bases de données séparées, mais connectées, interopérables et accessibles en cas de besoin ? Cette dernière option semble préférable en termes de sécurité. Il faut toutefois garder à l'esprit, comme pour contredire mes propos, que la plupart des établissements dans lesquels se trouvent actuellement les données, dont les hôpitaux, sont insuffisamment équipés en cybersécurité. La généralisation de solutions de type cloud est souhaitable, en premier lieu pour garantir un meilleur niveau de sécurité.

L'anonymisation est une question délicate. Se contenter de pseudonymiser les données n'est pas suffisant, car il est assez facile en pratique – et ce le sera de plus en plus – de les réidentifier dans bien des situations. Cela a été démontré de façon spectaculaire aux États-Unis par l'équipe de Latanya Sweeney qui a, dans des bases de données de santé publiques, accessibles, réidentifié le dossier du gouverneur du Massachusetts. D'un autre côté, utiliser d'autres techniques d'anonymisation plus brutales, consistant par exemple à mélanger les données de plusieurs individus, avec des moyennes, fait courir le risque de « tuer » des informations importantes. On s'achemine donc vers une doctrine subtile, encore à définir, quant au niveau d'anonymisation et à sa signification. Il faudra notamment tenir compte du risque en fonction des données, certaines étant plus engageantes que d'autres, ayant un gain potentiel supérieur. Il faudra concentrer l'attention sur les données pour lesquelles le gain est le plus important. Cela passe également par le développement de techniques dites de differential privacy ou « confidentialité différentielle », qui renvoient à l'idée d'afficher des données différentes en fonction de la personne qui demande, avec des autorisations négociées. Il s'agit de délivrer uniquement l'information nécessaire pour mener une recherche donnée, dans un cadre donné.

Vous avez également évoqué l'excès d'utilisation commerciale des données, qui se manifeste notamment par la multiplication de publicités ciblées. Il s'agit de l'une des grandes réalisations des dernières années : on peut désormais produire des publicités très efficaces, qui s'apparentent à de la manipulation et consistent à convaincre la personne visée qu'elle a besoin d'un produit ou d'un service, en lui envoyant les informations appropriées. Parfois, les opérateurs cachent ce type de démarche. Par exemple, le fait que des femmes enceintes aient reçu des publicités ciblées, alors même qu'elles n'avaient pas fait état de leur grossesse, avait suscité une certaine émotion. Les opérateurs avaient pris soin de noyer ces publicités parmi d'autres, afin de laisser croire qu'ils n'avaient pas identifié ces femmes, de la même manière que lorsqu'on a « craqué » le code d'un ennemi, on ne va pas seulement opérer dans son périmètre, mais frapper plus large, afin de ne pas dévoiler son jeu. Le RGPD comporte des éléments visant à limiter au maximum ces opérations de ciblage non souhaité.

Ce genre de pratique est bien décrit dans l'ouvrage de Catherine O'Neil sur les « armes de destruction mathématique ». La manipulation fait partie des fléaux du XXIe siècle. Or ce phénomène n'avait pas été anticipé. Pour information, les techniques de manipulation d'élections, ou les publicités reposant sur des identifications de personnes, se sont avérées très efficaces : elles réduisent la personnalité des gens à un ensemble de cinq paramètres seulement, selon un modèle dit « OCEAN », et permettent d'envoyer, selon les cas, des messages visant à inquiéter, rassurer, déranger la personne, ou à attirer son attention. La personnalité de chacun est identifiée en fonction de ses tweets, du nombre de clics effectués sur une page Facebook et des sites visités, via des cookies, etc. Le RGPD a également été conçu par rapport à ces aspects.

En ce qui concerne l'instance éthique à mettre en oeuvre pour réfléchir aux questions liées à l'intelligence artificielle et à son champ d'action, il faut trouver un compromis. Un comité d'éthique s'occupant de tous les problèmes éthiques du monde sera inefficace, dilué. Il est certain que l'intelligence artificielle a de grandes potentialités, pour l'instant très peu exploitées. La puissance publique a des difficultés à se saisir de ce sujet, qui n'entre pas vraiment dans les champs d'expertise actuels des différents ministères. Certaines sociétés existent déjà, qui proposent leurs services pour toutes sortes de sujets relatifs au développement durable, à l'agriculture augmentée, etc.

Quel risque est pire que celui de mourir ? Je partage, cher collègue, votre point de vue. Pour autant, dans le contexte actuel, de nombreuses questions se posent qui existaient déjà auparavant. Imaginons qu'un médecin découvre au détour d'un examen de routine que son patient est atteint d'une maladie incurable : doit-il le prévenir, sachant qu'il n'est absolument pas préparé à cette annonce ? Que faire si un médecin découvre lors d'un examen une information incidente, n'entrant pas dans le cadre de sa consultation ? Pour l'instant, l'avis de l'OPECST reflète bien ces hésitations, en gardant de façon générale l'idée qu'un médecin ne doit donner que les informations pour lesquelles il a été consulté, sauf pour certains gènes particuliers liés à un risque accru de cancer du sein. L'utilisation du génome dans la médecine préventive est, pour l'heure, plutôt décevante. Aucune avancée majeure n'a été effectuée dans ce domaine, en dehors du fait que tel ou tel gène précis, dans tel ou tel cas particulier, est impliqué. D'aucuns pensent par ailleurs qu'il serait préférable, avant d'analyser le génome, de s'intéresser au microbiote, qui a un impact important sur la santé et peut être analysé par des systèmes d'intelligence artificielle.

Vous avez dit que l'intelligence artificielle s'était développée à l'insu des experts et des décideurs et avait émergé sans que cela ait véritablement été anticipé. Finalement, quoi que l'on fasse, ce mouvement va nous échapper. Est-il donc bien nécessaire d'essayer de poser des limites ? En avons-nous vraiment les moyens, sachant que des pays comme la Chine consacrent des sommes phénoménales au développement de ces techniques, sans qu'on ait de surcroît connaissance de l'utilisation qu'ils vont en faire ?

Ne courons-nous pas, par ailleurs, le danger de voir se développer une société « à deux vitesses », entre les personnes qui voudront tout savoir, au risque d'être dans une sorte d'angoisse perpétuelle, et celles qui, au contraire, souhaiteront – à supposer qu'elles le puissent – conserver à leur vie une part d'imprévu, de surprise, de poésie ?

Merci beaucoup pour cet exposé et pour le rapport.

Les possibilités offertes par l'intelligence artificielle recèlent une part de magie. Or la magie relève d'un défaut de perception et j'ai le sentiment que l'on ne voit pas tout. Nous voyons bien les côtés positifs, mais vous avez aussi abordé les limites techniques et éthiques.

Mme Agnès Buzyn a annoncé que la médecine prenait un virage avec l'intelligence artificielle, passant d'un médecin porteur, grâce à sa mémoire, d'une base de données à un médecin n'ayant plus besoin de cette base car disposant de la possibilité d'utiliser l'intelligence artificielle et ses algorithmes. Au-delà de celle de la formation de nos médecins, je souhaiterais vous soumettre trois questions. Un médecin réalisant un diagnostic au moyen d'un outil de prédiction sera-t-il déchargé de toute responsabilité ? Qui sera responsable d'une erreur dans la détermination du niveau d'urgence dans la prise en charge d'un patient au regard d'une analyse prédictive ? Comment encadrer ou limiter cette responsabilité ?

Face à la volonté croissante de s'autogérer et à la difficulté, parfois, de trouver un médecin, de nombreux sites consacrés à la santé fleurissent sur Internet. Les outils prédictifs susceptibles d'être à la portée de n'importe quel internaute ne font-ils pas courir un risque d'automédication ? Ne va-t-on pas créer des générations d'« hypocondriaques numériques » ? Vous avez aussi évoqué la possibilité de panique – laquelle peut mener au suicide – face à l'annonce de mauvais résultats. Faut-il encadrer l'accès aux algorithmes de santé prédictive ?

Avons-nous les moyens ? Il est certain que nous ne parviendrons pas à mettre autant d'argent sur la table que la Chine, à moins d'une révolution politique européenne d'ampleur inouïe. Cela étant, quel est le risque majeur en la matière ? Il serait de ne pas développer d'outils ad hoc, auquel cas la pression qui s'exercera sur nos médecins et nos hôpitaux pour s'équiper de tels outils développés ailleurs sera énorme. Nous perdrons alors une bataille économique. Le secteur de la santé en lien avec l'intelligence artificielle est occupé par les grands acteurs américains, mais voit aussi émerger de nouveaux pays, comme Israël ou le Canada, où la société Element AI commence à travailler avec des hôpitaux, en particulier sur la question de la simplification logistique. Il nous faut de tels outils pour équiper nos hôpitaux et nos médecins, et si nous ne les produisons pas, nous les achèterons. Il importe donc, pour des raisons de souveraineté, de développer ces outils. Peut-être le développement de tels algorithmes n'est-il d'ailleurs pas uniquement lié au niveau des montants investis : il n'est pas exclu que 10 millions d'euros investis puissent conduire, en fin de compte, au même résultat qu'un investissement d'un milliard d'euros. Il convient de trouver un bon équilibre et de voir l'extérieur comme nous posant un défi, tout en nous concentrant sur ce que nous pouvons faire. Il faut également avoir conscience du fait qu'il existe une grande volonté de certains acteurs, tant du côté de l'algorithmique que du côté médical, de mettre en place des coopérations et d'exploiter les bases de données évoquées précédemment.

Le risque de voir se mettre en place une société à deux vitesses rejoint la question relative aux hypocondriaques numériques. Il existe déjà des personnes qui écument les forums sur internet pour expliquer leurs symptômes par le menu, tandis que d'autres ne souhaitent parler qu'à des spécialistes en qui ils ont confiance. La présence de circuits parallèles doit motiver les voies officielles pour être à l'écoute, expliquer, accompagner. Je ne vois pas se profiler de changement fondamental en la matière. On voit seulement s'accentuer certaines tendances qui existent déjà. Il faut juste être averti.

En ce qui concerne le virage de la médecine en lien avec le développement du numérique, il m'apparaît que le premier problème majeur qui va se poser est celui de la transformation de la formation des médecins. Passer d'un statut où la force du médecin réside en partie dans sa gigantesque mémoire et son extraordinaire expérience à un stade où il faudra arbitrer avec discernement entre plusieurs possibilités et cas repérés, et obtenus automatiquement, par la machine ne va pas de soi. Cela conduira assurément à un débat sur la perte de savoir-faire comparable à celui qui s'est produit lorsque l'écriture est apparue ou lorsque la numérisation a commencé. Il convient là aussi d'identifier clairement le risque principal, qui serait selon moi de ne rien faire, de laisser les formations dans leur état actuel et de ne changer que par petites doses. Dans ce cas, en effet, nos médecins ne seront pas au rendez-vous. S'ils ne savent pas bien utiliser les algorithmes, la pression exercée sur les hôpitaux sera importante pour faire venir de l'étranger des médecins formés à ces techniques et dont les compétences dans ce domaine rassureront les patients. Il est donc très important de se mettre à niveau, faute de quoi la maîtrise viendra de l'extérieur, avec un déficit économique à la clé, dans la mesure où il nous faudra importer le savoir-faire.

Le fait que la responsabilité revienne à l'humain est un principe sur lequel nous avons insisté dans le rapport et sur lequel, pour l'instant, les différents acteurs étatiques s'accordent. Il s'agit à mon sens d'un principe sain, qui évite de se défausser sur une entité non identifiée. Je suis donc opposé au concept de personnalité morale et juridique pour les algorithmes, même s'il est défendu avec panache et intelligence par des gens comme Alain Bensoussan.

Il ne faut pas imaginer qu'à cet égard une rupture va se produire par rapport à l'existant. Aujourd'hui, lorsqu'une faute médicale est constatée, on en recherche la raison : un appareil a-t-il été défectueux ? Un médecin a-t-il mal agi ? Les questions des assurances des médecins et des actions en justice se posent déjà. Elles continueront à se poser demain, avec un outil supplémentaire, l'outil algorithmique. En cas de défaillance, la responsabilité incombera-t-elle au directeur de la firme qui a vendu l'algorithme ? Au chef du département algorithmique ? Au médecin ? Il reviendra aux services juridiques et à la jurisprudence de se prononcer sur le partage des responsabilités.

L'audition s'achève à quatorze heures cinq.

Membres présents ou excusés

Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique

Réunion du mercredi 7 novembre 2018 à 11h30

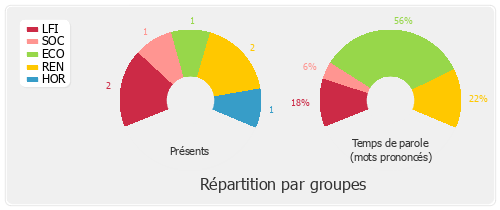

Présents. – M. Joël Aviragnet, M. Philippe Berta, M. Xavier Breton, Mme Blandine Brocard, M. Philippe Chalumeau, Mme Élise Fajgeles, Mme Emmanuelle Fontaine-Domeizel, M. Patrick Hetzel, M. Jean François Mbaye, M. Thomas Mesnier, Mme Marie Tamarelle-Verhaeghe, Mme Agnès Thill, M. Jean-Louis Touraine, Mme Annie Vidal

Excusée. - Mme Bérengère Poletti